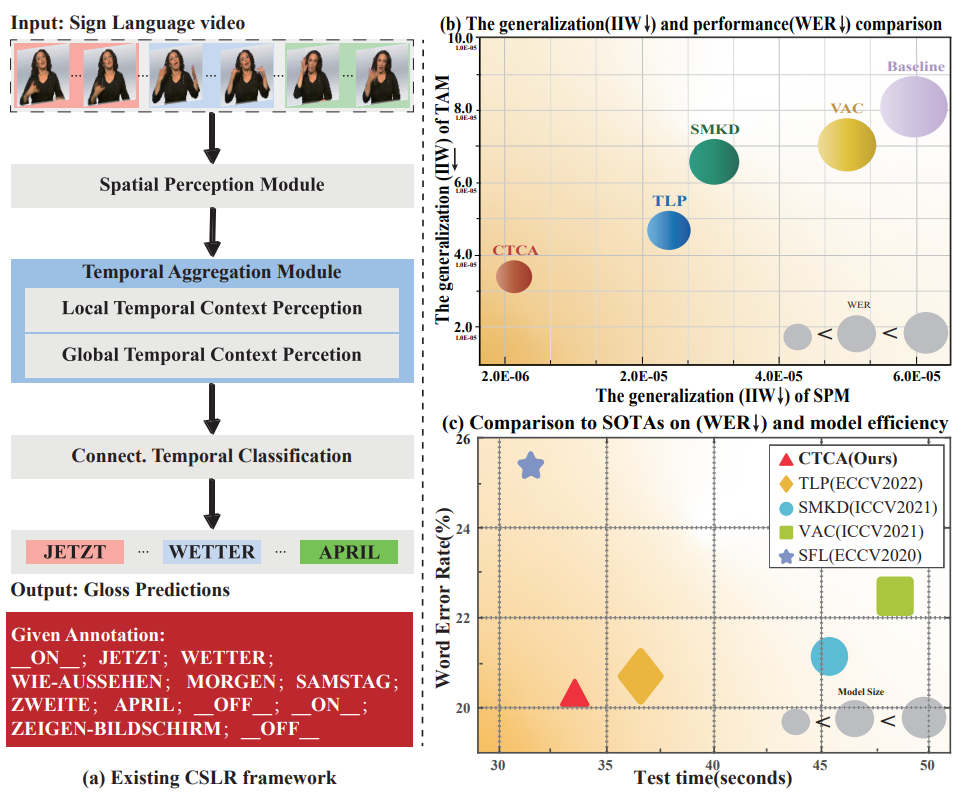

近日,由我院计算机视觉研究所陈胜勇教授、薛万利副教授共同指导的博士研究生郭乐铭撰写的论文“Distilling Cross-Temporal Contexts forContinuous Sign Language Recognition”被计算机视觉和人工智能领域国际公认的顶级会议IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR 2023)录用。该论文针对续手语识别框架中空间感知模型难以得到充分训练的问题开展研究,提出跨时序上下文聚合模型框架。该框架首次实现了期望的时序聚合模型在同时具备较短的链式深度以及较强的局部-全局时序感知能力两方面的平衡,在测试性能得分、模型参数规模、平均测试时间、模型泛化性等多项指标上均达到领先水平。

图1 所提方案整体结构及指标对比信息

计算机视觉研究所薛万利副教授课题组,三年来在人工智能计算机视觉领域的手语识别、目标跟踪和图象拼接方向上承担了国家自然科学基金等多项国家级科研任务;同时在CVPR、PR、IEEE-TCSVT、IEEE-TITS、IEEE-TVT、IEEE-TNSE等重要期刊和学术会议发表一系列研究成果,申请多项发明专利,在国际会议Neural Computing for Advanced Applications(NCAA2022)上获得最佳论文奖,同时在ICCV2021、ECCV2022的Visual Object Tracking VOT-LTChallenge中分获全球第4名和第3名。